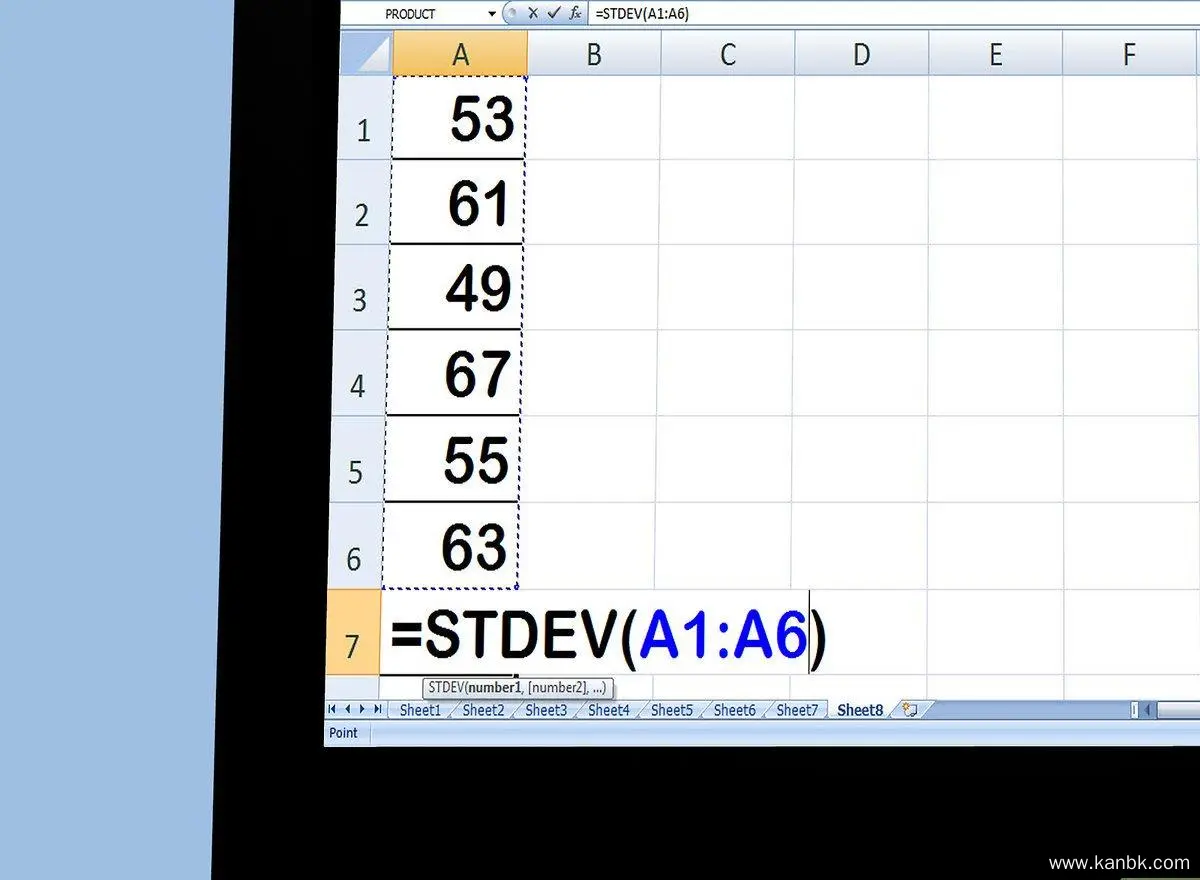

怎么计算标准差

答案未评审

修改时间

浏览量

标准差是统计学中用于衡量数据集的离散程度或变异性的一种度量。它描述了数据点相对于其平均值的分散程度。以下是详细介绍如何计算标准差的方法:

确定数据集: 首先,确定要计算标准差的数据集。数据集可以包含各种观测值、测量结果或样本。

计算平均值: 计算数据集的平均值,将所有数据点相加,然后除以数据点的总数。平均值表示数据集的中心位置。 平均值 = (数据点1 + 数据点2 + ... + 数据点n) / n

计算偏差: 对于每个数据点,计算其与平均值之间的偏差(即数据点减去平均值)。偏差衡量了每个数据点相对于平均值的距离。

计算偏差的平方: 将每个偏差值乘以自身,得到偏差的平方。这样做是为了消除负数,并突出显示较大的偏差对方差的影响。

计算方差: 将所有偏差的平方相加,并除以数据点的总数,得到方差的值。方差度量了数据点相对于平均值的离散程度。 方差 = (偏差的平方1 + 偏差的平方2 + ... + 偏差的平方n) / n

计算标准差: 标准差是方差的平方根。将方差的值开平方即可得到标准差的计算结果。

需要注意以下几点:

- 标准差提供了一种衡量数据集离散程度的方法。较大的标准差表示数据点更分散,而较小的标准差表示数据点更接近平均值。

- 标准差在统计学和概率论中有广泛的应用,用于描述数据的变异性和分布特征。

- 标准差是一个与原始数据具有相同单位的量,因为它是通过对方差进行平方根运算得到的。

总结而言,计算标准差需要确定数据集,计算平均值,然后计算每个数据点与平均值之间的偏差。将这些偏差的平方加起来,并除以数据点的总数,得到方差的值。最后,取方差的平方根即可得到标准差的值。标准差提供了一种衡量数据集离散程度的方法,对于数据分析和统计推断具有重要意义。